Қорқынышты ақиқат: дипфейк видеода бет-әлпетті, қозғалыс пен дауысты қалай өзгертеді

«Бұл рас па, жоқ па?» Тіпті, сөз сөйлеп тұрған адамның видеосы да енді жүз пайыз түпнұсқаның дәлелі бола алмайды. Бұл дипфейк болуы мүмкін, яғни, адамның дауысы мен бет-әлпеті өзгертілген видео.

Интернет қолданушылары дипфейктер туралы алғаш рет үш жыл бұрын естіген. Атауы – «терең оқыту» (ағылш. Deep Learning) және «жалған» (ағылш. Fake) сөздерінен құралған.

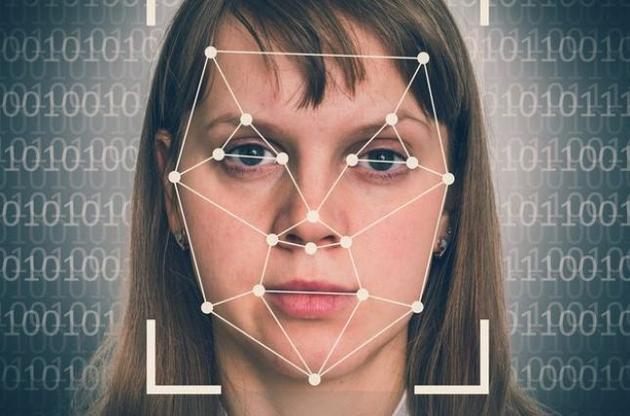

Желіде кейбір адамдардың бетін басқалардың жүзімен алмастыратын видеороликтердің жаңа форматы пайда болды. Генеративтік-жарысу желісі технологиясын (GAN) 2014 жылы Стэнфорд университетінің студенті Ян Гудфеллоу әзірлеген. Қарапайым сөзбен айтқанда, ол бір адамның жүзі әртүрлі түсірілген фотосуреттерді қатар көрсетеді. Бұл ретте жасанды интеллект көп суретті талдай отырып, нақты кейіпкердің қалай көрінетінін, сөйлейтінін және қозғалатынын үйренеді. Алгоритм екі видео араласып кетпей тұрғанда, оларды бір-бірімен «біріктіреді».

Алдымен технологияны жасанды интеллектіні зерттеушілер мен әзірлеушілер ғана қолданған.

Бірақ қазір дипфейктер барлық әлеуметтік желілерге тарады және кейде өте шынайы көрінеді. Мысалы, әртүрлі фильмдердің кейіпкерлерінің жүздері актер Николас Кейдждің бет-әлпетіне ауыстырылды.

Ал Флоридадағы Сальвадор Дали музейі осы технологияның көмегімен суретшіні «қайта тірілтті». vc.ru хабарлауынша, нәтижесінде көрермендер Далимен сөйлесіп, оның әңгімелерін тыңдап, бірге селфиге түскен. Бұл үшін Далидің 6000 фотосуреті, 1000 сағаттық машиналық жаттығу және пропорциялары ұқсас актермен 145 видео, сондай-ақ дауысын, акцентін және сөйлеу мәнерін жасау үшін суретшінің көптеген сұхбаттары мен хаттары қажет болды.

Бірақ қазір жалған видеолар Интернетте жиі шығады. Соңғы кездері оларды саяси фейк жаңалықтарда жиі қолданылып жүр. Әдетте, қоғамдық тұлғалардың беделін түсіру мақсатында.

Осындай алғашқы атышулы жағдайлардың бірі АҚШ Конгресі өкілдер палатасының спикері Нэнси Пелосидің сөйлеген сөзі болды. Оны Twitter мен Facebook желілерінде көп таратты. Бұл видеода автор спикердің сөйлеуі мен қозғалысын баяулатқан, ал пайдаланушылар оны мас екен деп ойлады. Екі күнде бұл видео 2 миллионнан астам мәрте қаралған.

Бұл – өте қарапайым дипфейк. Бірақ күрделі алгоритмдер бар. Бұл видеода адамның дауыс тембрін өзгертіп, сөзін баяулатып қана қоймай, адамның істемегенін істетіп, айтпағанын айтқызады.

Дипфейктердің қауіптілігі

Дипфейктер қазірдің өзінде шынайы көрінеді. Бұл технология саясатқа әсер етуі ықтимал. Болашақта мұндай видеолар ұлттық қауіпсіздікке қауіп төндіруі мүмкін, дейді сарапшылар.

«Аса маңызды шешімдер қабылданар сәтте шындықпен манипуляциялау өте қауіпті. Вирустық дипфейк видеолар саясаткерлер, брендтер және атақты адамдар сияқты беделді тұлғаларға деген сенімге нұқсан келтіріп қана қоймай, сондай-ақ, акциялардың құнына немесе жаһандық саяси шараларға да әсерін тигізіп, біздің қоғамға зиян келтіруі мүмкін. Кейбір адамдар дипфейктерді көңіл көтеру, әзіл үшін жасайды. Бірақ бұл технологиямен тәжірибе жасау ұйқыдағы алыпты оятумен бірдей. Бұл манипуляциялар мен зиянды әрекеттер аумағында қол бостықтан шектен шығу», – дейді Джозеф Энтони, Hero Group компаниясының бас директоры Forbes америкалық басылымына берген сұхбатында.

Дипфейкті қалай тануға болады

Дипфейк технологиясы одан әрі жетілдірілетіні анық. Уақыт өте келе өтірік пен шынды ажырату қиынға соғады. Бүгінде нарықта кез келген адам дипфейк жасай алатын ондаған қосымша бар, деп жазады (vc.ru).

«Менің ойымша, бұл жалған ақпарат пен фейк БАҚ-тың ең қауіпті бөліктерінің бірі», – дейді Олбанидегі Нью-Йорк Мемлекеттік университетінің информатика профессоры Сивей Лю.

Бұл күрделі мәселе, оны шешу мүмкін емес. Дегенмен салдарын азайтуға болады.

Оның жолдарының бірі – видео вирустық болмай тұрғанда оны бағалау үшін әлеуметтік желілерде біраз кідірту.

Үстіміздегі жылдың басында Facebook пайдаланушыларды шатастыруы мүмкін дипфейктерге тыйым салды. Кейіннен Twitter мен TikTok та тиісті ережелерді бекітті, деп хабарлайды BBC.

Дипфейктерді қалай жасаса, солай таниды — нейрожелілердің көмегімен. Өткен аптада Майкрософт осындай жалған мәліметтерді анықтауға арналған құрал әзірлегені белгілі болды. Бағдарламалық қамсыздандыру материалдың жасанды түрде жасалу ықтималдығын бағалау үшін фотосуреттер мен видеоларды талдайды.

Фирма технология «жалған ақпаратпен күресуге» септігін тигізеді деп үміттенеді.

Бірақ кейбір сарапшылар дипфейк технологияларының даму қарқынына байланысты бағдарламаның тез ескіру қаупі бар деп санайды.

Бұл мәселені шешу үшін Майкрософт жеке жүйені де таныстырды. Аталған технология контентті өндірушілерге видео материалдарға жасырын код қосуға көмектеседі. Бұдан кейін түпнұсқадағы кез келген өзгерістерді оңай және автоматты түрде анықтауға болады.

Өз кезегінде Google жасанды интеллектіні жалған бейнелерді анықтауға үйрету үшін мыңдаған дипфейктің мәліметтер базасын жасады. Бұған дейін Facebook жалған видеоларға қарсы күресу үшін Microsoft және Partnership on AI ғалымдарымен бірікті. Тараптар дипфейктерді анықтау бойынша ең жақсы шешімге Deepfake Detection Challenge конкурсын жариялады.

Мамандар алгоритмдерді зерттеп, тексеруге арналған технологияларды жасағанша әлеуметтік желілерді пайдаланушылар не істеуі керек?

«Басты төреші көрермен болуы керек. Біз қандай контентті көріп, тарататынымызға үлкен мән беруіміз керек», – деді Ақпараттық технологиялар саласындағы сарапшы Хани Фарид.

Вашингтон университетінің зерттеушілері Джевин Вест пен Карл Бергстрем нақты адамдардың портреттерін нейрондық желіні жасаушылар әзірлегендерден ажыратуға мүмкіндік беретін сайт жасады. Суреттердің жартысын StyleGAN алгоритмі түрлендіреді, ал қалғаны ашық дереккөздерден алынады. Өзіңіздің бет-әлпетті тану дағдыңызды тексеріңіз – бұл оңай емес.