Пугающе реально: как в дипфейк-видео подменяют лица, движения и голос

Это правда или нет? Даже видеоролик, в котором вы видите говорящего человека, уже не является стопроцентным доказательством подлинности. Вполне возможно, что перед вами дипфейк — видео, в котором подменили не только голос, но и лицо.

О дипфейках пользователи Интернета впервые услышали три года назад. Дипфейк — это комбинация слов «глубокое обучение» (англ. deep learning) и «подделка» (англ. fake).

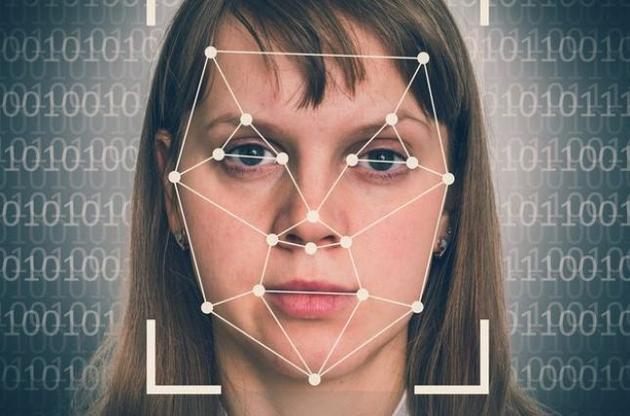

В Сети появился новый формат видеороликов, на которых лица одних людей заменяют другими. Технологию генеративно-состязательной сети (GAN) еще в 2014 году разработал студент Стэнфордского университета Ян Гудфеллоу. Если говорить просто, то она соединяла фотографии одного и того же человека с разным выражением лица в один видеоряд. При этом искусственный интеллект, анализируя большое количество снимков, учится тому, как выглядит, говорит и двигается конкретный персонаж. Алгоритм «смешивает» два видео, пока они не «сливаются» друг с другом.

Вот как это работает:

Сначала технологию использовали только исследователи и разработчики искусственного интеллекта.

Но сейчас дипфейки распространились во всех соцсетях и порой выглядят так реалистично, что становится не по себе. Вот, например, лица героев разных фильмов поменяли на лицо актера Николаса Кейджа.

А вот Музей Сальвадора Дали во Флориде «оживил» художника с помощью все той же технологии. В результате, как пишет vc.ru, зрители могли пообщаться с Дали, послушать его истории и даже получить совместное селфи. Для этого потребовалось 6000 фотографий Дали, 1000 часов машинного обучения и 145 видео с актером похожих пропорций, а еще горы интервью и писем художника, чтобы воспроизвести голос, акцент и манеру речи.

Сейчас поддельные видео нередко появляются в Интернете и не всегда для развлечения. В последнее время их все чаще используют в фейковых политических новостях. Как правило, цель — дискредитация публичных личностей.

Одним из первых таких нашумевших примеров было видео с выступлением Спикера Палаты представителей Конгресса США Нэнси Пелоси. Его активно распространяли в сетях Twitter и Facebook. В этом видеоролике автор замедлил речь и движения спикера так, чтобы пользователи решили, что она выступает нетрезвой. За двое суток этот ролик был просмотрен более 2 миллионов раз.

Этот дипфейк был сделан достаточно просто. Но есть и сложные алгоритмы. Они не просто меняют тембр голоса или замедляют речь, а генерируют такие видео, на которых человек делает то, чего никогда не делал, или говорит то, чего никогда не говорил.

Опасность дипфейков

Дипфейки уже сейчас выглядят все более реалистичными. Эта технология претендует на то, чтобы влиять на политику. По мнению экспертов, в дальнейшем такие видео и вовсе могут стать угрозой национальной безопасности.

«Манипулировать правдой чрезвычайно опасно, когда на чаше весов находятся важные решения, а ставки высоки по всем направлениям. Вирусные дипфейк-видео не только подрывают доверие к влиятельным людям, таким как политики, бренды и знаменитости, они потенциально могут причинить вред нашему обществу, влияя на цены акций или глобальные политические меры. Хотя некоторые люди создают их для забавы и юмора, экспериментировать с этой технологией все равно что разбудить спящего гиганта. Это выходит за рамки безделья, на территорию манипуляций и злонамеренных действий», — сказал Джозеф Энтони, генеральный директор Hero Group в интервью американскому изданию Forbes.

Как распознать дипфейк

Уже ясно, что технология «дипфейк» будет становиться все лучше и лучше. И со временем отличить ложь от правды станет все сложнее. Сейчас на рынке десятки приложений, с помощью которых любой может сделать дипфейк, пишет vc.ru.

«Я думаю, что на самом деле это одна из самых опасных частей дезинформации и фейковых СМИ», — цитирует NY times слова Сивэй Лю, профессора информатики Государственного университета Нью-Йорка в Олбани.

Это серьезная проблема, решить которую практически невозможно. Но можно уменьшить неприятные последствия.

Один из подходов — это предварительная задержка в социальных сетях для оценки видео, прежде чем они станут вирусными (Forbes).

В начале этого года Facebook запретил дипфейки, которые могут вводить пользователей в заблуждение. Позже Twitter и TikTok установили аналогичные правила, сообщает BBC.

Распознают дипфейки точно так же, как и создают — с помощью нейросетей. На прошлой неделе стало известно, что Microsoft разработала инструмент для выявления таких подделок. Программное обеспечение анализирует фотографии и видео, чтобы оценить вероятность того, что материал был создан искусственно.

Фирма надеется, что технология поможет «бороться с дезинформацией».

Но некоторые эксперты считают, что она рискует быстро устареть из-за темпов развития дипфейк-технологий.

Чтобы решить эту проблему, Microsoft также анонсировала отдельную систему. Эта технология поможет производителям контента добавлять скрытый код в свои видеоматериалы. И потом любые изменения оригинала можно будет обнаружить автоматически.

Google в свою очередь создал базу данных из тысяч дипфейков, чтобы обучить искусственный интеллект выявлять поддельные видео. А ранее Facebook для борьбы с фейковыми видео объединился с Microsoft и учеными из Partnership on AI. Стороны объявили о конкурсе Deepfake Detection Challenge на лучшее решение по обнаружению дипфейков.

Но что делать пользователям соцсетей, пока специалисты изучают алгоритмы и создают технологии для проверки?

«Главным судьей должен быть зритель. Нам необходимо проявлять большую разборчивость в том, какой контент мы смотрим и распространяем», — уверен Хани Фарид, эксперт в области информационных технологий.

Исследователи Вашингтонского университета Джевин Вест и Карл Бергстрем создали сайт, который предлагает всем желающим отличить портреты реальных людей от тех, что создает нейросеть. Половину изображений генерирует алгоритм StyleGAN, а остальные берутся из открытых источников. Проверьте свои навыки распознавания лиц — сделать это очень непросто.